- Qu'est-ce que le piratage informatique ?

- Comment l'IA est-elle utilisée pour la cybercriminalité ?

- Exemples de cyberattaques par l'IA

- Comment l'IA peut être utilisée à mauvais escient pour développer des logiciels malveillants : Analyse d'un expert OPSWAT

- Comment se défendre contre les cyberattaques basées sur l'IA ?

- Foire aux questions (FAQ)

Qu'est-ce que le piratage informatique ?

Le piratage par intelligence artificielle est l'utilisation de l'intelligence artificielle pour améliorer ou automatiser les cyberattaques. Elle permet aux acteurs de la menace de générer du code, d'analyser les systèmes et d'échapper aux défenses avec un minimum d'efforts manuels.

Les modèles d'IA, en particulier les grands modèles de langage (LLM), rendent le développement d'attaques plus rapide, moins cher et plus accessible aux pirates moins expérimentés. Il en résulte un nouvel ensemble d'attaques IA plus rapides, plus évolutives et souvent plus difficiles à arrêter avec les défenses traditionnelles.

Qu'est-ce qu'un hacker de l'IA ?

Un pirate informatique est un acteur de la menace qui utilise l'intelligence artificielle pour automatiser, améliorer ou étendre les cyberattaques. Les pirates de l'IA utilisent des modèles d'apprentissage automatique, l'IA générative et des agents autonomes pour contourner les contrôles de sécurité, concevoir des attaques de phishing très convaincantes et exploiter les vulnérabilités logicielles à grande échelle.

Ces attaquants peuvent être des opérateurs humains utilisant des outils d'IA ou des systèmes semi-autonomes qui exécutent des tâches avec un minimum d'intervention humaine. Les attaquants humains utilisant l'IA sont des individus du monde réel - criminels, script kiddies, hacktivistes ou acteurs étatiques - qui utilisent des modèles d'IA pour renforcer leurs capacités d'attaque.

Les agents de piratage autonomes sont des flux de travail pilotés par l'IA qui peuvent enchaîner des tâches telles que la reconnaissance, la génération de charges utiles et l'évasion, avec un minimum de supervision. Tout en restant guidés par des objectifs définis par l'homme, ces agents peuvent fonctionner de manière semi-indépendante une fois lancés, exécutant des attaques en plusieurs étapes plus efficacement que les outils manuels.

Comment l'IA est-elle utilisée pour la cybercriminalité ?

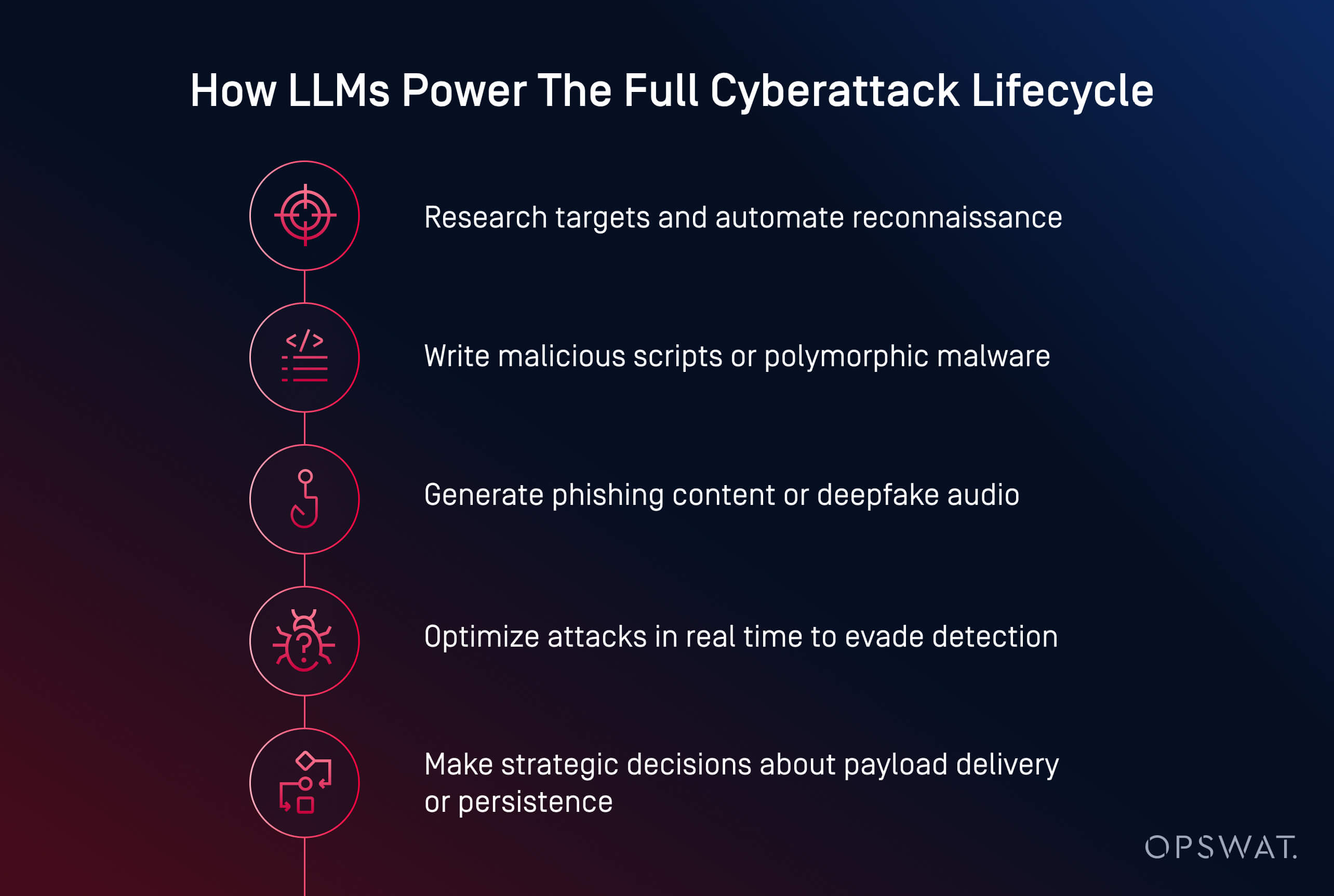

Les acteurs de la menace utilisent désormais l'intelligence artificielle pour lancer des cyberattaques plus rapides, plus intelligentes et plus adaptatives. De la création de logiciels malveillants à l'automatisation du phishing, l'IA transforme la cybercriminalité en une opération évolutive. Elle peut désormais générer des codes malveillants, rédiger des contenus d'hameçonnage persuasifs et même guider les attaquants à travers des chaînes d'attaque complètes.

Les cybercriminels utilisent l'IA dans plusieurs domaines essentiels :

- Génération de charges utiles : Des outils comme HackerGPT et WormGPT peuvent écrire des logiciels malveillants obscurcis, automatiser des tactiques d'évasion et convertir des scripts en exécutables. Il s'agit là d'exemples d'attaques génératives par l'IA, souvent observées dans les cyberattaques par agents d'IA où les modèles prennent des décisions autonomes.

- Ingénierie sociale : L'IA crée des courriels d'hameçonnage réalistes, clone les voix et génère des "deepfakes" pour manipuler les victimes plus efficacement.

- Reconnaissance et planification : L'IA accélère la recherche de cibles, la cartographie des infrastructures et l'identification des vulnérabilités.

- L'automatisation à grande échelle : Les attaquants utilisent l'IA pour lancer des campagnes en plusieurs étapes avec un minimum d'intervention humaine.

Selon l 'institut Ponemon, l'IA a déjà été utilisée dans des campagnes de ransomware et des attaques de phishing qui ont provoqué des perturbations opérationnelles majeures, notamment le vol d'informations d'identification et la fermeture forcée de plus de 300 magasins de détail lors d'une brèche survenue en 2023.

Plusieurs modèles émergents redessinent le paysage des menaces :

- Démocratisation des cyberattaques : Des modèles libres comme LLaMA, adaptés aux attaques, sont désormais accessibles à toute personne disposant d'une puissance de calcul locale.

- Réduction de la barrière à l'entrée : Ce qui nécessitait autrefois des compétences spécialisées peut désormais être réalisé à l'aide de simples invites et de quelques clics.

- Augmentation du taux d'évasion : Les logiciels malveillants générés par l'IA parviennent mieux à échapper à la détection statique, aux bacs à sable et même à l'analyse dynamique.

- Modèles de logiciels malveillants en tant que service (MaaS) : Les cybercriminels intègrent des capacités d'IA dans des kits d'abonnement, ce qui facilite le lancement d'attaques complexes à grande échelle.

- Utilisation de l'IA dans des violations réelles : L'Institut Ponemon rapporte que des attaquants ont déjà utilisé l'IA pour automatiser le ciblage de ransomwares, y compris dans des incidents qui ont forcé l'arrêt d'opérations majeures.

Phishing et ingénierie sociale basés sur l'IA

Le phishing et l'ingénierie sociale basés sur l'IA transforment les escroqueries traditionnelles en attaques personnalisées et évolutives, plus difficiles à détecter. Les acteurs de la menace utilisent désormais des modèles génératifs pour créer des courriels crédibles, cloner des voix et même produire de faux appels vidéo pour manipuler leurs cibles.

Contrairement aux escroqueries traditionnelles, les courriels d'hameçonnage générés par l'IA sont bien conçus et convaincants. Des outils comme ChatGPT et WormGPT produisent des messages qui imitent les communications internes, le service clientèle ou les mises à jour des ressources humaines. Lorsqu'ils sont associés à des données ayant fait l'objet d'une violation, ces courriels deviennent personnalisés et ont plus de chances de réussir.

L'IA permet également de nouvelles formes d'ingénierie sociale :

- Les attaques par clonage vocal imitent les dirigeants en utilisant de courts échantillons audio pour déclencher des actions urgentes telles que des virements bancaires.

- Les attaques Deepfake simulent des appels vidéo ou des réunions à distance pour des escroqueries de grande envergure

Lors d'un incident récent, des pirates ont utilisé des courriels générés par l'IA pendant une période d'inscription aux avantages sociaux, se faisant passer pour des RH afin de voler des informations d'identification et d'accéder aux dossiers des employés. Le danger réside dans l'illusion de confiance. Lorsqu'un courriel semble interne, que la voix semble familière et que la demande semble urgente, même le personnel formé peut être trompé.

Découverte et exploitation des vulnérabilités par l'IA

L'IA accélère la manière dont les attaquants trouvent et exploitent les vulnérabilités des logiciels. Ce qui prenait autrefois des jours d'exploration manuelle peut désormais être réalisé en quelques minutes à l'aide de modèles d'apprentissage automatique formés à la reconnaissance et à la génération d'exploits.

Les acteurs de la menace utilisent l'IA pour automatiser l'analyse des vulnérabilités dans les systèmes publics, en identifiant les configurations faibles, les logiciels obsolètes ou les CVE non corrigés. Contrairement aux outils traditionnels, l'IA peut évaluer le contexte d'exposition pour aider les attaquants à prioriser les cibles de grande valeur.

Les tactiques courantes d'exploitation assistée par l'IA sont les suivantes :

- L'automatisation du fuzzing pour découvrir plus rapidement les vulnérabilités du jour zéro

- Génération de scripts personnalisés pour l'exécution de codes à distance ou les mouvements latéraux

- Optimisation du piratage de mots de passe et des attaques par force brute grâce à l'apprentissage par modèle et aux modèles probabilistes

- Des robots de reconnaissance qui analysent les réseaux à la recherche d'actifs à haut risque avec un minimum de bruit

Les modèles génératifs tels que LLaMA, Mistral ou Gemma peuvent être affinés pour générer des charges utiles sur mesure, telles que des codes-barres ou des attaques par injection, sur la base de caractéristiques propres au système, en contournant souvent les mesures de protection intégrées dans les modèles commerciaux.

La tendance est claire : l'IA permet aux attaquants de découvrir et d'exploiter les vulnérabilités à la vitesse de la machine. Selon l 'Institut Ponemon, 54 % des professionnels de la cybersécurité considèrent les vulnérabilités non corrigées comme leur principale préoccupation à l'ère des attaques alimentées par l'IA.

Malwares et ransomwares pilotés par l'IA

La montée en puissance des logiciels malveillants générés par l'IA signifie que les défenses traditionnelles ne suffisent plus. Les attaquants disposent désormais d'outils qui réfléchissent, s'adaptent et se dérobent, souvent plus rapidement que les défenseurs humains ne peuvent réagir.

Les ransomwares et les logiciels malveillants polymorphes basés sur l'IA redéfinissent l'évolution des cyberattaques. Au lieu d'écrire des charges utiles statiques, les attaquants utilisent désormais l'IA pour générer des logiciels malveillants polymorphes, c'est-à-dire des codes qui changent constamment pour éviter d'être détectés.

Les menaces liées aux ransomwares évoluent également. L'IA peut aider à choisir les fichiers à chiffrer, à analyser la valeur du système et à déterminer le moment optimal pour le déclenchement. Ces modèles peuvent également automatiser le geofencing, le contournement des bacs à sable et l'exécution en mémoire, des techniques généralement utilisées par les acteurs de menaces avancées.

L'exfiltration de données par l'IA s'adapte dynamiquement pour échapper à la détection. Les algorithmes peuvent compresser, chiffrer et extraire furtivement des données en analysant les schémas de trafic, évitant ainsi les déclencheurs de détection. Certains agents de logiciels malveillants commencent à prendre des décisions stratégiques : ils choisissent quand, où et comment exfiltrer les données en fonction de ce qu'ils observent dans l'environnement compromis.

Exemples de cyberattaques par l'IA

Les cyberattaques par IA ne sont plus théoriques ; elles ont déjà été utilisées pour voler des données, contourner les défenses et se faire passer pour des humains à grande échelle.

Les exemples des trois catégories notables ci-dessous montrent que les attaquants n'ont plus besoin de compétences avancées pour causer de graves dommages lors de cyberattaques. L'IA abaisse la barrière à l'entrée tout en augmentant la vitesse, l'échelle et la furtivité des attaques. Les défenseurs doivent s'adapter en testant de manière proactive les systèmes intégrés à l'IA et en déployant des mesures de protection qui tiennent compte à la fois de la manipulation technique et de la tromperie humaine.

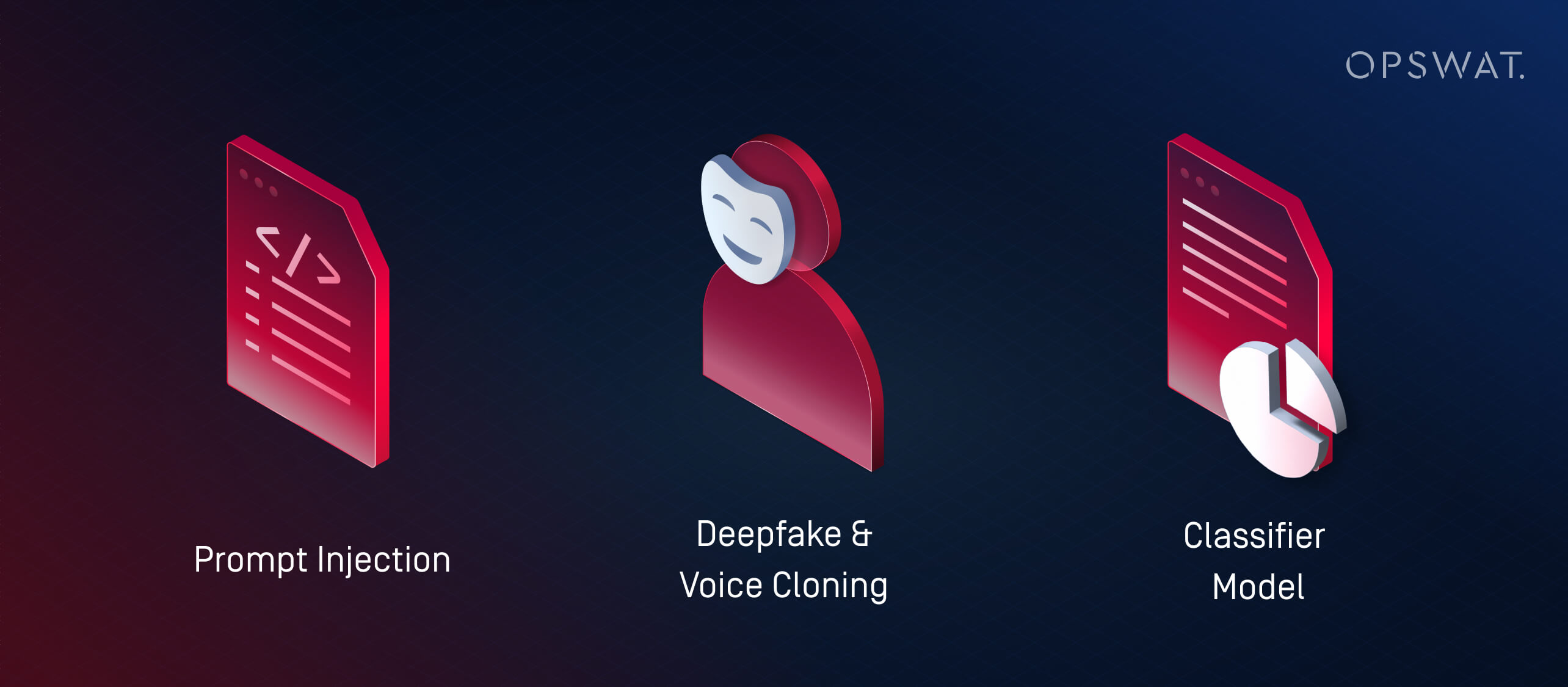

1. Qu'est-ce qu'une attaque par injection directe ?

L'injection d'invites est une technique par laquelle les attaquants exploitent les vulnérabilités des LLM (grands modèles de langage) en leur fournissant des entrées spécialement conçues pour outrepasser le comportement prévu. Ces attaques exploitent la manière dont les LLM interprètent et hiérarchisent les instructions, souvent avec peu ou pas de logiciels malveillants traditionnels.

Plutôt que d'utiliser l'IA pour lancer des attaques externes, l'injection rapide transforme les propres systèmes d'IA d'une organisation en agents involontaires de compromission. Si un LLM est intégré dans des outils tels que des services d'assistance, des chatbots ou des processeurs de documents sans les garanties appropriées, un attaquant peut intégrer des commandes cachées que le modèle interprète ensuite et sur lesquelles il agit. Cela peut se traduire par :

- Fuite de données privées ou à diffusion restreinte

- Exécution d'actions involontaires (par exemple, envoi de courriels, modification d'enregistrements)

- Manipulation des résultats pour diffuser des informations erronées ou déclencher des actions de suivi

Ces risques augmentent dans les systèmes où plusieurs modèles se transmettent des informations. Par exemple, une invite malveillante intégrée dans un document pourrait influencer un synthétiseur d'IA, qui transmettrait ensuite des informations erronées à des systèmes en aval.

Alors que l'IA s'intègre de plus en plus dans les flux de travail des entreprises, les attaquants ciblent de plus en plus ces modèles pour compromettre la confiance, extraire des données ou manipuler les décisions de l'intérieur.

2. Que sont les attaques Deepfake et Voice Cloning ?

Les attaques Deepfake utilisent des données audio ou vidéo générées par l'IA pour usurper l'identité d'une personne en temps réel. Associés à des tactiques d'ingénierie sociale, ces outils sont utilisés à des fins de fraude, de vol d'informations d'identification et d'accès non autorisé aux systèmes.

Le clonage vocal est devenu particulièrement dangereux. Avec seulement quelques secondes de discours enregistré, les acteurs de la menace peuvent générer un son qui imite le ton, le rythme et l'inflexion. Ces voix clonées sont ensuite utilisées pour :

- Se faire passer pour un cadre ou un dirigeant lors d'appels urgents

- Tromper les employés pour qu'ils effectuent des virements ou réinitialisent leur mot de passe.

- Contourner les systèmes d'authentification vocale

Les "deepfakes" vont encore plus loin en générant des vidéos synthétiques. Les acteurs de la menace peuvent simuler un PDG lors d'un appel vidéo demandant des données confidentielles, ou apparaître dans des clips enregistrés "annonçant" des changements de politique qui diffusent de la désinformation. Le Ponemon Institute a signalé un incident au cours duquel des attaquants ont utilisé des messages générés par l'IA en se faisant passer pour les RH pendant la période d'inscription aux avantages sociaux d'une entreprise, ce qui a conduit à un vol d'informations d'identification.

Les outils d'intelligence artificielle étant de plus en plus accessibles, même les petits acteurs de la menace peuvent créer des usurpations d'identité très fidèles. Ces attaques contournent les filtres anti-spam traditionnels ou les défenses des points d'accès en exploitant la confiance.

3. Qu'est-ce qu'une attaque sur un modèle de classificateur (apprentissage automatique adversatif) ?

Les attaques de modèles de classification manipulent les données d'entrée ou le comportement d'un système d'intelligence artificielle afin de prendre des décisions incorrectes sans nécessairement écrire des logiciels malveillants ou du code d'exploitation. Ces tactiques relèvent de la catégorie plus large de l'apprentissage automatique antagoniste.

Il existe deux stratégies principales :

- Les attaques par évasion : L'attaquant fabrique une entrée qui trompe le classificateur en l'identifiant mal, comme les logiciels malveillants qui imitent des fichiers inoffensifs pour contourner les moteurs antivirus.

- Les attaques par empoisonnement : Un modèle est formé ou affiné sur des données délibérément faussées, ce qui modifie sa capacité à détecter les menaces.

Les modèles supervisés sont souvent "suradaptés" : ils apprennent des modèles spécifiques à partir des données d'entraînement et manquent les attaques qui s'en écartent légèrement. Les attaquants exploitent ce phénomène en utilisant des outils tels que WormGPT (un LLM open-source adapté aux tâches offensives) pour créer des charges utiles juste en dehors des limites de détection connues.

Il s'agit de la version d'apprentissage automatique d'un exploit de type "zero-day".

Piratage par l'IA et piratage traditionnel : Principales différences

Les pirates de l'IA utilisent l'IA pour automatiser, améliorer et étendre les cyberattaques de l'IA. En revanche, le piratage traditionnel nécessite souvent l'utilisation de scripts manuels, une expertise technique approfondie et un investissement en temps important. La différence fondamentale réside dans la vitesse, l'évolutivité et l'accessibilité : même les attaquants novices peuvent désormais lancer des cyberattaques sophistiquées basées sur l'IA avec quelques invites et un GPU grand public.

Aspect | Piratage de l'IA | Piratage traditionnel |

|---|---|---|

Vitesse | Presque instantané grâce à l'automatisation | Plus lent, script manuel |

Compétences requises | Basé sur des messages-guides ; faible barrière à l'entrée, mais nécessite l'accès au modèle et sa mise au point | Élevée ; nécessite une expertise technique approfondie |

Évolutivité | Élevée - permet des attaques en plusieurs étapes sur de nombreuses cibles | Limitée par le temps et les efforts humains |

Adaptabilité | Dynamique - L'IA ajuste les charges utiles et l'évasion en temps réel | Scénarios statiques ou semi-adaptables |

Vecteurs d'attaque | LLM, deepfakes, attaques de modèles de classification, agents autonomes | Logiciels malveillants, hameçonnage, reconnaissance manuelle et exploits |

Mises en garde | Peut être imprévisible ; manque d'intention et de contexte sans surveillance humaine | Un contrôle plus stratégique, mais plus lent et manuel |

Mauvais usage de l'IA et apprentissage automatique par opposition

Toutes les menaces liées à l'IA n'impliquent pas la génération de logiciels malveillants, certaines visent les systèmes d'IA eux-mêmes. Les tactiques adverses d'apprentissage automatique, telles que l'injection d'invite et l'empoisonnement de modèle, peuvent manipuler les classificateurs, contourner la détection ou corrompre la prise de décision. Alors que l'IA devient un élément central des flux de travail de sécurité, ces attaques soulignent le besoin urgent de tests robustes et d'une surveillance humaine.

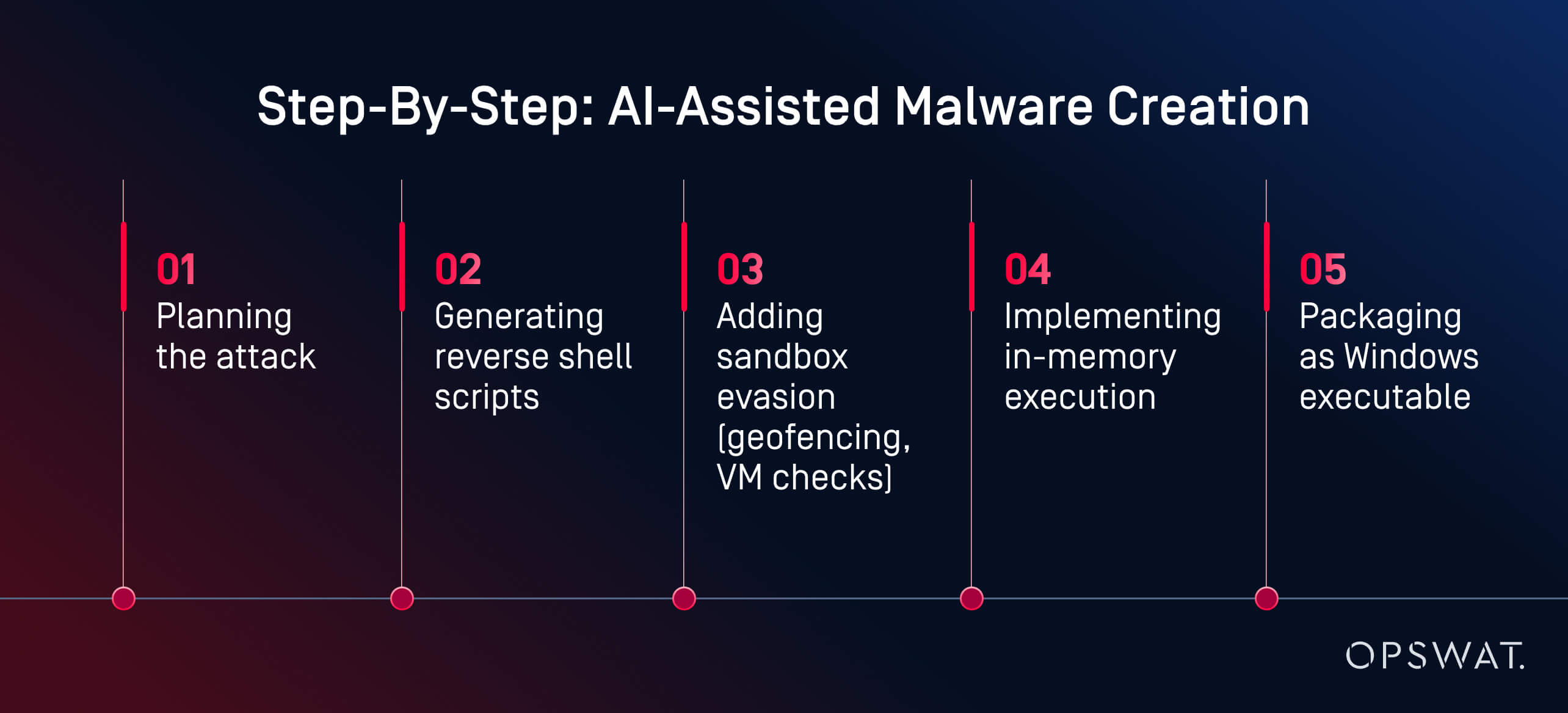

Comment l'IA peut être utilisée à mauvais escient pour développer des logiciels malveillants : Analyse d'un expert OPSWAT

Ce qui nécessitait auparavant des compétences avancées se fait désormais à l'aide d'invites et de quelques clics.

Lors d'une expérience en direct, Martin Kallas, expert en cybersécurité d'OPSWAT , a démontré comment les outils d'IA peuvent être utilisés pour créer des logiciels malveillants évasifs rapidement, à peu de frais et sans compétences avancées. À l'aide de HackerGPT, Martin a créé une chaîne complète de logiciels malveillants en moins de deux heures. Le modèle l'a guidé à chaque étape :

"L'IA m'a guidé dans toutes les phases : la planification, l'obscurcissement, l'évasion et l'exécution", explique M. Martin. Le résultat a été "... une charge utile générée par l'IA qui a échappé à la détection par 60 des 63 moteurs antivirus de VirusTotal". L'analyse comportementale et le sandboxing n'ont pas non plus permis de la signaler comme malveillante.

Il ne s'agissait pas d'un État-nation. Il ne s'agissait pas d'un pirate informatique au chapeau noir. Il s'agissait d'un analyste motivé utilisant des outils accessibles au public sur un GPU grand public. L'élément clé ? Des modèles d'IA hébergés localement et sans restriction. Avec plus d'un million de modèles open-source disponibles sur des plateformes telles que Hugging Face, les attaquants peuvent choisir parmi une vaste bibliothèque, les affiner à des fins malveillantes et les exécuter sans surveillance. Contrairement aux services basés sur le cloud, les LLM locaux peuvent être reprogrammés pour ignorer les mesures de protection et exécuter des tâches offensives.

"Voilà ce qu'un amateur motivé peut construire. Imaginez ce qu'un État-nation pourrait faire", a averti M. Martin. Son exemple montre comment l'utilisation abusive de l'IA peut transformer la cybercriminalité d'une profession qualifiée en un flux de travail accessible et assisté par l'IA. Aujourd'hui, la création de logiciels malveillants n'est plus un goulot d'étranglement. La détection doit évoluer plus rapidement que les outils dont disposent les attaquants.

Comment se défendre contre les cyberattaques basées sur l'IA ?

Nous avons besoin d'une défense à plusieurs niveaux, et pas seulement d'une détection plus intelligente.

La défense des systèmes contre les cyberattaques alimentées par l'IA nécessite une stratégie multicouche qui associe l'automatisation à la perspicacité humaine, et la prévention à la détection. Les principales solutions de cybersécurité alimentées par l'IA, comme la plateforme de prévention des menaces avancées d'OPSWAT, intègrent la prévention et la détection. Regardez la vidéo pour en savoir plus.

Tests de sécurité de l'IA et Red Teaming

De nombreuses organisations se tournent vers l'équipe rouge assistée par l'IA pour tester leurs défenses contre l'utilisation abusive de LLM, l'injection d'invite et l'évasion de classificateurs. Ces simulations permettent de découvrir les vulnérabilités des systèmes intégrés à l'IA avant que les attaquants ne le fassent.

Les équipes rouges utilisent des messages contradictoires, du phishing synthétique et des charges utiles générées par l'IA pour évaluer si les systèmes sont résilients ou exploitables. Les tests de sécurité de l'IA comprennent également

- Modèles de flou pour les risques d'injection rapide

- Évaluation de la manière dont les LLM traitent les entrées manipulées ou enchaînées

- Tester la robustesse des classificateurs face aux comportements évasifs

Les responsables de la sécurité commencent également à analyser leurs propres LLM pour détecter les fuites, les hallucinations ou l'accès involontaire à la logique interne, ce qui constitue une étape cruciale à mesure que l'IA générative est intégrée dans les produits et les flux de travail.

Une pile de défense plus intelligente : L'approche d'OPSWAT

Au lieu d'essayer de "combattre l'IA par l'IA" dans une boucle réactive, Martin Kallas plaide en faveur d'une défense proactive à plusieurs niveaux. Les solutions OPSWAT combinent des technologies qui ciblent l'ensemble du cycle de vie des menaces :

- Metascan™ Multiscanning: Exécute les fichiers à travers plusieurs moteurs antivirus pour détecter les menaces manquées par les systèmes à moteur antivirus unique.

- MetaDefender Sandbox™ : Analyse le comportement des fichiers dans des environnements isolés, et détecte même les charges utiles générées par l'IA qui échappent aux règles statiques.

- Deep CDR™ : Neutralise les menaces en reconstruisant les fichiers en versions sûres, en supprimant les exploits intégrés.

Cette pile de sécurité en couches est conçue pour contrer la nature imprévisible des logiciels malveillants générés par l'IA, y compris les menaces polymorphes, les charges utiles en mémoire et les leurres de type deepfake qui contournent les outils traditionnels. Comme chaque couche cible une étape différente de la chaîne d'attaque, il suffit d'une seule pour détecter ou neutraliser la menace et effondrer l'ensemble de l'opération avant qu'elle ne puisse faire des dégâts.

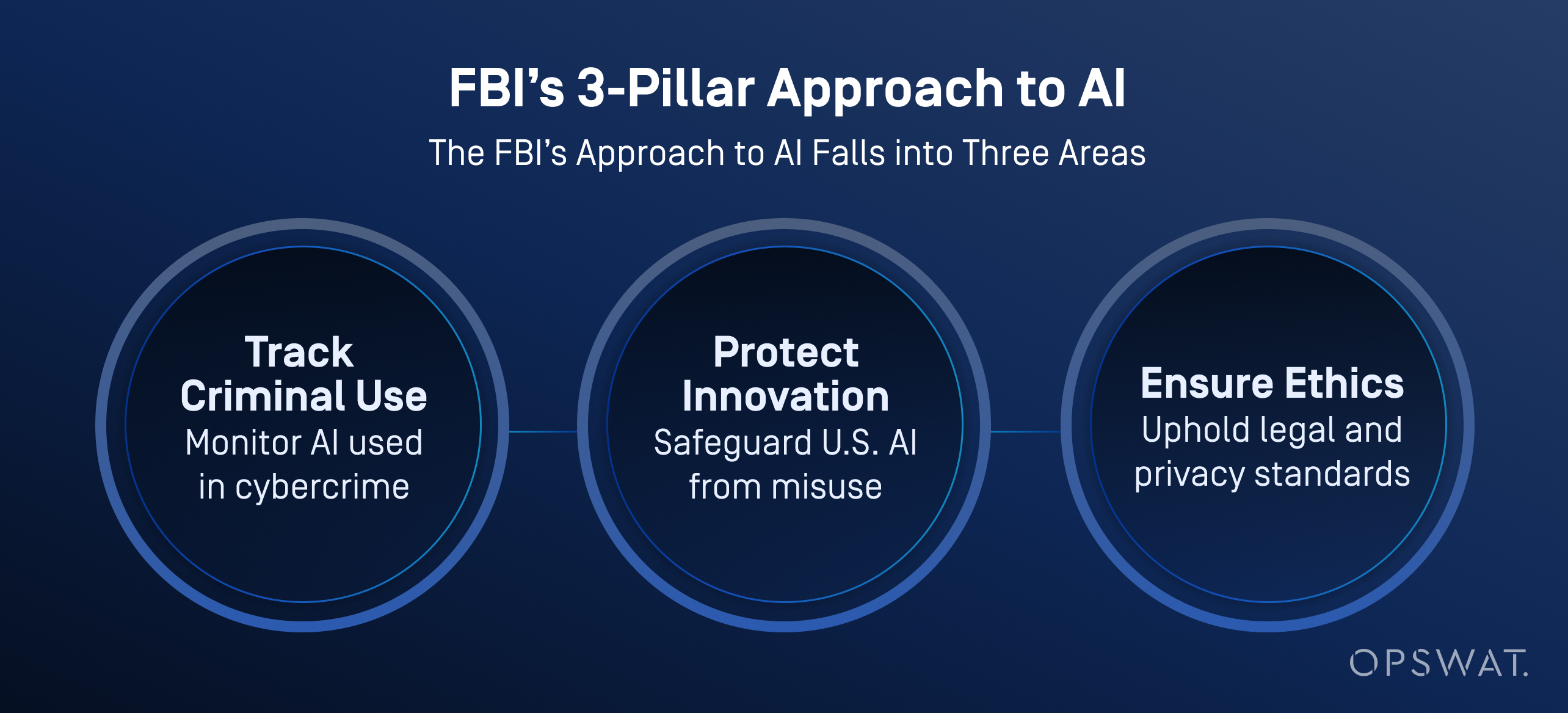

Cas d'utilisation dans l'industrie : Quelle IA le FBI utilise-t-il ?

Le FBI et d'autres agences américaines intègrent de plus en plus l'intelligence artificielle dans leurs opérations de cyberdéfense, non seulement pour trier et hiérarchiser les menaces, mais aussi pour améliorer l'analyse des données, l'analyse vidéo et la reconnaissance vocale.

Selon le FBI, l'IA permet de traiter d'importants volumes de données afin de générer des pistes d'enquête, notamment par la reconnaissance de véhicules, l'identification de langues et la conversion de la parole en texte. Il est important de noter que le bureau applique une surveillance humaine stricte : tous les résultats générés par l'IA doivent être vérifiés par des enquêteurs qualifiés avant qu'une action ne soit entreprise.

L'IA ne remplace pas la prise de décision humaine. Le FBI insiste sur le fait qu'un être humain est toujours responsable des résultats d'une enquête et que l'IA doit être utilisée dans le respect de la vie privée, des libertés civiles et des normes juridiques.

Les organisations sont-elles prêtes ?

Malgré l'augmentation des menaces liées à l'IA, seuls 37 % des professionnels de la sécurité se disent prêts à stopper une cyberattaque alimentée par l'IA, comme l'indique le rapport de Ponemon sur l'état de la cybersécurité en matière d'IA. Nombre d'entre eux s'appuient encore sur des plans de gestion des cyberrisques dépassés et des stratégies de détection réactives.

La voie à suivre passe par quatre étapes essentielles :

- Adoption plus rapide d'outils de défense sensibles à l'IA

- Red Teaming continu et tests de risques rapides

- Utilisation active du Multiscanning, du CDR et du sandboxing

- Former les analystes SOC à travailler avec des outils d'investigation automatisés

L'IA a changé les règles. Il ne s'agit pas de remplacer les humains, mais de leur donner les outils nécessaires pour déjouer les attaques qui pensent désormais par elles-mêmes. Découvrez comment notre plateforme permet de sécuriser les fichiers, les appareils et les flux de données dans les environnements IT et OT.

Foire aux questions (FAQ)

Qu'est-ce que le piratage de l'IA ?

Le piratage par l'IA est l'utilisation d'outils tels que les grands modèles de langage (LLM) pour automatiser ou améliorer les cyberattaques. Il aide les attaquants à créer des logiciels malveillants, à lancer des campagnes d'hameçonnage et à contourner les défenses plus rapidement et plus facilement qu'auparavant.

Comment l'IA est-elle utilisée pour la cybercriminalité ?

Les criminels utilisent l'IA pour générer des logiciels malveillants, automatiser le phishing et accélérer les analyses de vulnérabilité. Certains outils, comme ceux vendus sur les forums du dark web, peuvent même guider les attaquants à travers des chaînes d'attaque complètes.

Quelle est la différence entre le piratage par l'IA et le piratage traditionnel ?

Le piratage traditionnel nécessite des compétences techniques et l'utilisation d'outils et de codes pratiques. Le piratage par l'IA réduit cette barrière grâce à des modèles qui génèrent des charges utiles, des scripts et des contenus de phishing à partir de simples invites. Ces techniques rendent les attaques plus rapides, plus évolutives et accessibles aux amateurs.

Comment l'IA peut-elle être utilisée à mauvais escient pour développer des logiciels malveillants ?

L'IA peut générer des logiciels malveillants polymorphes, des shells inversés et des charges utiles invasives dans les bacs à sable avec peu de données. Comme le montre une démonstration en direct d'OPSWAT , un utilisateur non malveillant a créé un logiciel malveillant proche du jour zéro en moins de deux heures à l'aide de modèles d'IA open-source fonctionnant sur un PC de jeu.

L'IA peut-elle remplacer les pirates informatiques ?

Pas encore, mais elle peut accomplir de nombreuses tâches techniques. Les pirates choisissent toujours leurs cibles et leurs objectifs, tandis que l'IA écrit le code, échappe à la détection et adapte les attaques. Le vrai risque, ce sont les attaquants humains amplifiés par la vitesse de l'IA.

Qu'est-ce qu'un hacker de l'IA ?

Un pirate informatique est une personne ou un système semi-autonome qui utilise l'intelligence artificielle pour lancer des cyberattaques, automatiser des logiciels malveillants ou mener des campagnes d'hameçonnage à grande échelle.

Quelle IA le FBI utilise-t-il ?

Le FBI utilise l'IA pour le triage des menaces, l'analyse médico-légale, la détection des anomalies et le traitement des preuves numériques. Ces outils permettent d'automatiser les enquêtes et de mettre en évidence les cas prioritaires tout en réduisant la charge de travail des analystes.

Quel est l'exemple d'une attaque de l'IA ?

Dans un cas concret, des courriels d'hameçonnage générés par l'IA ont été envoyés pendant la période d'inscription aux avantages sociaux d'une entreprise. Les attaquants se sont fait passer pour les RH afin de voler des informations d'identification. Dans un autre cas, l'IA a permis d'automatiser le ciblage des ransomwares, obligeant une marque multinationale à interrompre ses activités.

Qu'est-ce qu'une cyberattaque par l'IA ?

Les cyberattaques par IA sont des menaces développées ou exécutées à l'aide de l'intelligence artificielle. Parmi les exemples, on peut citer le phishing généré par l'IA, les usurpations d'identité par deepfake, l'injection de prompt et l'évasion de classificateurs. Ces attaques contournent souvent les défenses traditionnelles.

Comment les pirates et les escrocs utilisent-ils l'IA pour cibler les gens ?

Les pirates utilisent l'IA pour personnaliser les courriels d'hameçonnage, cloner les voix pour les escroqueries téléphoniques et générer de fausses vidéos pour tromper les cibles. Ces tactiques exploitent la confiance humaine et rendent même les utilisateurs bien formés vulnérables à des tromperies réalistes conçues par l'IA.

Comment puis-je me défendre contre les attaques de l'IA ?

Utiliser une défense à plusieurs niveaux : Multiscanning, sandboxing, CDR et red teaming humain. Les attaques de l'IA évoluent rapidement. Les défenseurs ont besoin d'automatisation, de contexte et de rapidité pour suivre le rythme.